2019年9月

撰写于 浏览:2060 次 分类: 决策树面试

算法工程师在实际求职面试中,决策树内容几乎是机器学习领域必考必问的知识点,因为它不仅是常见的机器学习模型,更是在许多互联网公司实际业务中得到广泛的使用。决策树模型具有可解释性,容易向业务部门人员描述。而且决策树模型分类速度很快,很受互联网公司的欢迎。决策树面试问题1:什么是决策树?决策树面试问题2:和其他模型比,决策树的优点?决策树面试问题3:如何[...]

撰写于 浏览:1191 次 分类: 决策树

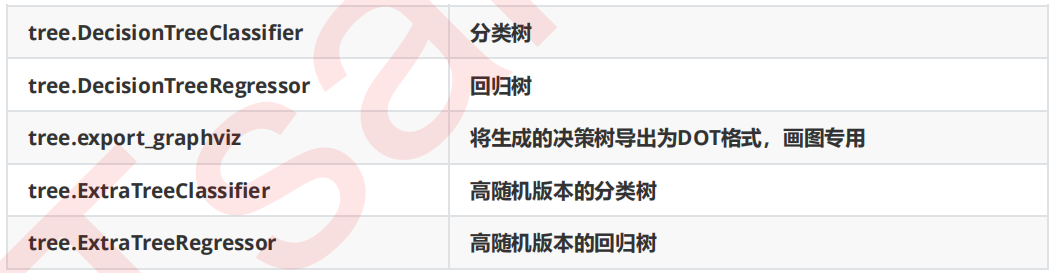

1、scikit-learn中的决策树决策树是一个非参数的监督式学习方法,主要用于分类和回归。决策树算法的目标是通过推断数据特征,学习决策规则从而创建一个预测目标变量的模型。scikit-learn中决策树的类都在sklearn.tree这个模块之下,这个模块总共包含五个类:2、scikit-learn的安装scikit-learn是一个用于机器学[...]

撰写于 浏览:1076 次 分类: 决策树

决策树学习采用的是自顶向下的递归方法,其基本思想是以信息熵为度量构造一颗熵值下降最快的树,到叶子节点处,熵值为0。其具有可读性、分类速度快的优点,是一种有监督学习。最早提及决策树思想的是Quinlan在1986年提出的ID3算法和1993年提出的C4.5算法,以及Breiman等人在1984年提出的CART算法。决策树的构造过程一般分为3个部分,分[...]

撰写于 浏览:1016 次 分类: 决策树

决策树的优点是简单,逻辑清晰,具备可解释性,但是也有一个很大的缺点:非常容易过拟合,解决过拟合的方法主要是有剪枝、随机森林等。从随机森林的名字上就能猜出,这种方法无非是信奉”人多力量大“这句话,把诸多决策树集成在一起,进而形成一个更强大的树树树模型。随机森林是一个Bagging方法,Bagging是一种有放回抽样方法:取出一个样本加入训练集,然后再[...]

撰写于 浏览:955 次 分类: 决策树

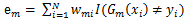

Boosting 是一类算法的总称,这类算法的特点是通过训练若干弱分类器,然后将弱分类器组合成强分类器进行分类。为什么要这样做呢?因为弱分类器训练起来很容易,将弱分类器集成起来,往往可以得到很好的效果。俗话说,"三个臭皮匠,顶个诸葛亮",就是这个道理。这类 Boosting 算法的特点是各个弱分类器之间是串行训练的,当前弱分类器的训练依赖于上一轮弱[...]